Propaganda

A história da computação está cheia de falhanços.

o Apple III tinha o hábito desagradável de se cozinhar em sua concha deformada. o Atari Jaguar, um console de jogos "inovador" que tinha algumas alegações espúrias sobre seu desempenho, simplesmente não conseguiu conquistar o mercado. O principal chip Pentium da Intel, projetado para aplicativos de contabilidade de alto desempenho, dificuldade com números decimais.

Mas o outro tipo de fracasso que prevalece no mundo da computação é o FLOPS por muito tempo aclamada como uma comparação razoavelmente justa entre diferentes máquinas, arquiteturas e sistemas.

FLOPS é uma medida de operações de ponto flutuante por segundo. Simplificando, é o velocímetro de um sistema de computação. E tem sido crescendo exponencialmente por décadas.

E se eu disser a você que em alguns anos você terá um sistema em sua mesa, na sua TV ou no seu telefone, que limparia o chão dos supercomputadores de hoje? Incrível? Eu sou louco? Dê uma olhada na história antes de julgar.

Supercomputador para Supermercado

Um recente Intel i7 Haswell Então, qual é a diferença entre os processadores Haswell e Ivy Bridge da Intel?Procurando um novo computador? Quem está comprando um novo laptop ou desktop equipado com Intel precisa saber as diferenças entre a última e a última geração de processadores Intel. consulte Mais informação processador pode executar cerca de 177 bilhões FLOPS (GFLOPS), mais rápido que o supercomputador mais rápido dos EUA em 1994, o Laboratório Nacional Sandia XP / s140 com 3.680 núcleos de computação trabalhando juntos.

Um PlayStation 4 pode operar a cerca de 1,8 trilhão de FLOPS graças ao seu avançado Micro-arquitetura celular, e teria superado o US $ 55 milhões em vermelho ASCI supercomputador que liderou a liga mundial de supercomputadores em 1998, quase 15 anos antes do lançamento do PS4.

Da IBM Watson AI System IBM revela revolucionário "cérebro em um chip"Anunciado na semana passada por meio de um artigo na Science, "TrueNorth" é o que é conhecido como "chip neuromórfico" - um chip de computador projetado para imitar neurônios biológicos, para uso em sistemas inteligentes de computadores como Watson. consulte Mais informação tem um (atual) pico de operação 80 TFLOPS, e isso está longe de ser incluído na lista das 500 melhores dos supercomputadores de hoje, com o Chinês Tianhe-2 liderando o Top 500 nas últimas 3 ocasiões consecutivas, com um desempenho máximo de 54,902 TFLOPS, ou quase 55 Peta-FLOPS.

A grande questão é: onde está o próximo supercomputador de mesa A mais recente tecnologia de computador que você precisa ver para acreditarConfira algumas das mais recentes tecnologias de computador que devem transformar o mundo da eletrônica e dos PCs nos próximos anos. consulte Mais informação vai vir? E o mais importante, quando vamos conseguir isso?

Outro tijolo na parede do poder

Na história recente, as forças motrizes entre esses ganhos impressionantes em velocidade foram em ciência dos materiais e design de arquitetura; processos de fabricação em escala nanométrica menor significam que os chips podem ser mais finos, mais rápidos e descarregar menos energia na forma de calor, o que os torna mais baratos de operar.

Além disso, com o desenvolvimento de arquiteturas multinúcleo durante o final dos anos 2000, muitos "processadores" agora são compactados em um único chip. Essa tecnologia, combinada com a crescente maturidade dos sistemas de computação distribuídos, onde muitos "Computadores" podem operar como uma única máquina, significa que o Top 500 sempre cresceu, apenas para manter ritmo com Lei famosa de Moore.

No entanto, o leis da física estão começando a atrapalhar todo esse crescimento, até Intel está preocupado com isso, e muitos em todo o mundo estão procurando a próxima coisa.

... em cerca de dez anos, mais ou menos, veremos o colapso da Lei de Moore. De fato, já vemos uma desaceleração da Lei de Moore. A energia do computador simplesmente não pode manter seu rápido aumento exponencial usando a tecnologia padrão de silício. - Dr. Michio Kaku – 2012

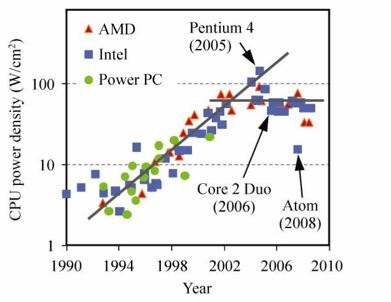

O problema fundamental no projeto de processamento atual é que os transistores estão ligados (1) ou desligados (0). Cada vez que um porta do transistor 'Vira', ele tem que expelir uma certa quantidade de energia para o material de que o portão é feito para fazer com que esse 'virar' fique. À medida que esses portões ficam cada vez menores, a relação entre a energia para usar o transistor e o energia para 'virar' o transistor aumenta cada vez mais, criando maior aquecimento e confiabilidade problemas Os sistemas atuais estão se aproximando - e em alguns casos excedendo - a densidade de calor bruto dos reatores nucleares, e os materiais estão começando a falhar com seus projetistas. Isso é chamado classicamente de "Power Wall".

Recentemente, alguns começaram a pensar de maneira diferente sobre como executar cálculos úteis. Duas empresas em particular chamaram nossa atenção em termos de formas avançadas de computação quântica e óptica. canadense Sistemas D-Wave e no Reino Unido Optalysys, que têm abordagens extremamente diferentes para conjuntos de problemas muito diferentes.

Hora de mudar a música

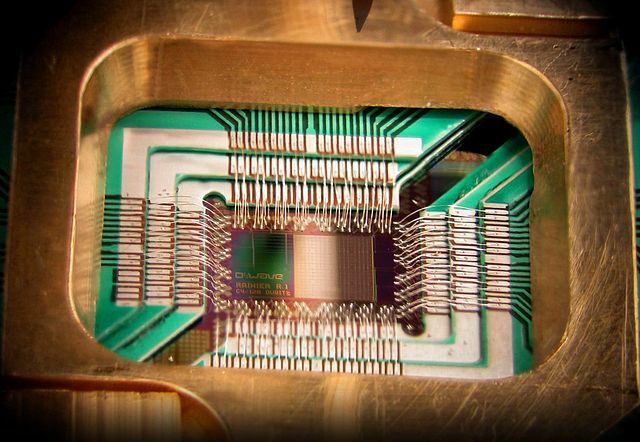

Ultimamente, a D-Wave recebeu muita imprensa, com sua caixa preta super-resfriada com um pico interno de cyberpunk, contendo um enigmático chip nu com poderes difíceis de imaginar.

Em essência, o sistema D2 adota uma abordagem completamente diferente para a solução de problemas, lançando efetivamente o livro de regras de causa e efeito. Então, que tipo de problemas esse gigante do Google / NASA / Lockheed Martin tem como objetivo?

The Rambling Man

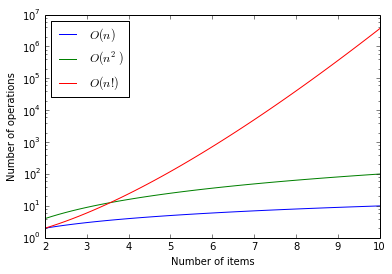

Historicamente, se você deseja resolver um Problema NP-Difícil ou Intermediário, onde há um número extremamente alto de soluções possíveis com um amplo leque de potencial, usando "valores" a abordagem clássica simplesmente não funciona. Tomemos, por exemplo, o problema do vendedor ambulante; dadas as N-cidades, encontre o caminho mais curto para visitar todas as cidades uma vez. É importante observar que o TSP é um fator importante em muitos campos, como fabricação de microchips, logística e até mesmo sequenciamento de DNA,

Mas todos esses problemas se resumem a um processo aparentemente simples; Escolha um ponto para começar, gere uma rota em torno de N 'coisas', meça a distância e, se houver uma rota mais curta que ela, descarte a rota tentada e passe para a próxima até que não haja mais rotas para Verifica.

Isso parece fácil e, para pequenos valores, é; para 3 cidades, há 3 * 2 * 1 = 6 rotas a serem verificadas, para 7 cidades existem 7 * 6 * 5 * 4 * 3 * 2 * 1 = 5040, o que não é muito ruim para um computador. Isto é um Fatorial sequência e pode ser expresso como "N!", então 5040 é 7 !.

No entanto, quando você vai um pouco mais longe, para 10 cidades para visitar, você precisa testar mais de 3 milhões de rotas. Quando você chega a 100, o número de rotas que você precisa verificar é 9 seguido por 157 dígitos. A única maneira de analisar esse tipo de função é usar um gráfico logarítmico, em que o eixo y começa em 1 (10 ^ 0), 10 (10 ^ 1), 100 (10 ^ 2), 1000 (10 ^ 3). ) e assim por diante.

Os números ficam grandes demais para serem capazes de processar razoavelmente em qualquer máquina que existe hoje ou pode existir usando arquiteturas clássicas de computação. Mas o que a D-Wave está fazendo é muito diferente.

Emerge o Vesúvio

O chip do Vesúvio no D2 usa cerca de 500 ‘qubitsQuant ou Quantum Bits para executar esses cálculos usando um método chamado Recozimento Quântico. Em vez de medir cada rota de cada vez, o Vesuvius Qubits é colocado em um estado de superposição (nem ligado nem desligado, operando juntos como um tipo de campo potencial) e uma série de descrições algébricas cada vez mais complexas da solução (ou seja, uma série do Hamiltoniano descrições da solução, não uma solução em si) são aplicadas ao campo de superposição.

De fato, o sistema está testando a adequação de todas as soluções em potencial simultaneamente, como uma bola 'decidindo' que caminho descer uma colina. Quando a superposição é relaxada em um estado fundamental, esse estado fundamental dos qubits deve descrever a solução ideal.

Muitos questionaram quanto de vantagem o sistema D-Wave oferece sobre um computador convencional. Em um teste recente da plataforma contra um problema típico do Traveling Saleman, que levou 30 minutos para um computador clássico, levou apenas meio segundo no Vesúvio.

No entanto, para ficar claro, isso nunca será um sistema no qual você joga o Doom. Alguns comentaristas estão tentando compare este sistema altamente especializado com um processador de uso geral. Seria melhor comparar um Ohiosubmarino de classe com o F35 Lightning; qualquer métrica que você selecionar para uma é tão inadequada para a outra que é inútil.

O D-Wave está chegando a várias ordens de magnitude mais rapidamente devido a problemas específicos em comparação com um processador padrão, e o FLOPS estimativas variam de 420 GFLOPS relativamente impressionantes para 1,5 Peta-FLOPS impressionantes (Colocando-o na lista dos 10 melhores supercomputadores em 2013 na época do último protótipo público). De qualquer forma, essa disparidade destaca o início do fim do FLOPS como uma medida universal quando aplicada a áreas problemáticas específicas.

Esta área da computação visa um conjunto muito específico (e muito interessante) de problemas. O preocupante é que um dos problemas nessa esfera é criptografia Como criptografar seu Gmail, Outlook e outro WebmailAs contas de email mantêm as chaves das suas informações pessoais. Veja como criptografar seu Gmail, Outlook.com e outras contas de email. consulte Mais informação - especificamente criptografia de chave pública.

Felizmente, a implementação do D-Wave parece focada em algoritmos de otimização, e o D-Wave tomou algumas decisões de projeto (como a estrutura hierárquica de pares no chip) que indicam que você não poderia usar o Vesúvio para resolver Algoritmo de Shor, o que potencialmente desbloquearia a Internet tão mal isso deixaria Robert Redford orgulhoso.

Laser Maths

A segunda empresa da nossa lista é a Optalysys. Esta empresa sediada no Reino Unido pega a computação e a inverte usando superposição analógica de luz para executar certas classes de computação usando a natureza da própria luz. O vídeo abaixo demonstra alguns dos antecedentes e fundamentos do sistema Optalysys, apresentados por Prof. Heinz Wolff.

É um pouco ondulado, mas, em essência, é uma caixa que esperamos que um dia fique na sua mesa e fornecer suporte computacional para simulações, CAD / CAM e imagens médicas (e talvez, apenas talvez, computadores) jogos). Como o Vesúvio, não há como a solução Optalysys realizar tarefas de computação convencionais, mas não é para isso que ela foi projetada.

Uma maneira útil de pensar sobre esse estilo de processamento óptico é pensar como uma GPU (Unidade de processamento gráfico) física. GPU moderna Conheça o seu acelerador gráfico em detalhes excruciantes com o GPU-Z [Windows]A GPU, ou unidade de processamento gráfico, é a parte do seu computador encarregada de manipular gráficos. Em outras palavras, se os jogos estiverem instáveis no seu computador ou ele não conseguir lidar com configurações de qualidade muito alta, ... consulte Mais informação Usamos muitos processadores de streaming em paralelo, realizando o mesmo cálculo em diferentes dados provenientes de diferentes áreas da memória. Essa arquitetura surgiu como resultado natural da maneira como os gráficos de computador são gerados, mas essa arquitetura massivamente paralela tem sido usada para tudo, desde negociação de alta frequência, para Redes neurais artificiais.

A Optalsys adota princípios semelhantes e os traduz em um meio físico; particionamento de dados torna-se divisão de feixe, álgebra linear torna-se interferência quântica, As funções de estilo MapReduce tornam-se sistemas de filtragem óptica. E todas essas funções operam em tempo constante, efetivamente instantâneo.

O protótipo inicial usa uma grade de elementos de 20Hz 500 × 500 para realizar transformações rápidas de Fourier (basicamente, “que frequências aparecem nesse fluxo de entrada?”) e forneceu um equivalente abaixo do esperado do 40 GFLOPS. Os desenvolvedores estão visando um sistema 340 GFLOPS por Próximo ano, que, considerando o consumo estimado de energia, seria uma pontuação impressionante.

Então, onde está minha caixa preta?

o história da computação Uma Breve História dos Computadores que Mudaram o MundoVocê pode passar anos investigando a história do computador. Há toneladas de invenções, toneladas de livros sobre elas - e isso é antes de você começar a apontar o dedo que inevitavelmente ocorre quando ... consulte Mais informação mostra-nos que o que inicialmente é a reserva de laboratórios de pesquisa e agências governamentais rapidamente entra no hardware do consumidor. Infelizmente, a história da computação ainda não teve que lidar com as limitações das leis da física.

Pessoalmente, não acho que a D-Wave e a Optalysys sejam as tecnologias exatas que temos em nossas mesas daqui a 5 a 10 anos. Considere que o primeiro reconhecível "Relógio inteligente" foi revelado em 2000 e falhou miseravelmente; mas a essência da tecnologia continua hoje. Da mesma forma, essas explorações nos aceleradores de computação Quântica e Óptica provavelmente acabarão como notas de rodapé na "próxima grande novidade".

A ciência dos materiais está chegando mais perto computadores biológicos, usando estruturas semelhantes a DNA para executar matemática. Nanotecnologia e "Matéria programável" está se aproximando do ponto em que, em vez de processar "dados", o próprio material conterá, representará e processará informações.

Em suma, é um mundo novo e corajoso para um cientista computacional. Onde você acha que tudo isso está indo? Vamos conversar sobre isso nos comentários!

Créditos fotográficos:KL Intel Pentium A80501 por Konstantin Lanzet, Asci vermelho - tflop4m pelo governo dos EUA - Sandia National Laboratories, DWave D2 pelo Vancouver Sun, DWave 128chip por D-Wave Systems, Inc., Problema do Vendedor Viajante por Randall Munroe (XKCD)

Durante o dia, sou um pesquisador da Universidade de Liverpool que investiga Confiança e reputação em comunicações marítimas para sistemas autônomos de sistemas. À noite, sou o diretor fundador do Farset Labs, o First Hackerspace da Irlanda do Norte, além de consultar consultores locais. governo, negócios, academia e o setor voluntário de Extensão STEM, Estratégia de Inovação Empresarial e Comunicações e Segurança de dados.